A inteligência artificial chegou à remuneração estratégica cercada de ruído e, por isso mesmo, precisa ser tratada com método. O ponto não é “usar IA” como um fim em si, mas tornar decisões críticas (metas, métricas, curvas e custos) mais defensáveis, consistentes e testáveis. Na prática, a IA muda menos o que fazemos em remuneração e muda muito o como fazemos: ela desloca o processo de um debate baseado em percepções para uma disciplina baseada em probabilidade, cenários, otimização e governança.

Este artigo organiza, com rigor técnico, onde a IA realmente agrega valor em remuneração variável (RV) e Incentivos de Longo Prazo (ILP), com foco em definição de metas e simulações. Também incorpora aprendizados práticos discutidos no ecossistema de remuneração, incluindo o debate sobre dados públicos e governança em ILP e Formulário de Referência (CVM), e o uso de arquiteturas como RAG (técnica que conecta as ferramentas, como ChatGPT a uma base proprietária de dados de forma segura) e agentes para reduzir alucinação e aumentar rastreabilidade.

A ideia central: IA não “decide remuneração”; ela melhora a decisão

Há uma confusão frequente: tratar IA como “substituto do comitê” ou como “automação de planilha”. Na remuneração estratégica, a contribuição relevante da IA é outra: transformar decisões que sempre foram difíceis em decisões mais bem informadas, ao permitir analisar mais dados, simular mais futuros e documentar melhor por que uma decisão foi tomada.

Essa perspectiva é coerente com o que consultorias globais têm enfatizado: o valor está em dados confiáveis, governança, integração de fontes e transparência sobre como as respostas foram geradas, especialmente quando as decisões serão questionadas por finanças, auditoria, conselho e — cada vez mais — pelos próprios colaboradores.

Onde a IA entra na remuneração

Uma forma clara de “tirar o assunto do barulho” é separar aplicações por maturidade e impacto:

1- Automação baseada em regras (o básico bem feito)

Aqui entram regras de elegibilidade, cálculos de payout, validações e fluxos de aprovação. É útil para reduzir erro operacional, mas não é o núcleo estratégico da discussão. Na prática, essa camada equivale ao “se acontecer X, então Y”, com menor complexidade.

É quando a remuneração passa a se apoiar em modelos que projetam eventos futuros a partir de históricos: risco de turnover, variações de indicadores e padrões de atingimento. O ganho aqui é trocar “chute bem-intencionado” por estimativas probabilísticas.

3- Simulação e otimização (o salto de qualidade)

Quando previsões alimentam simulações (cenários, Monte Carlo, stress tests) e, em seguida, algoritmos ajudam a calibrar metas, curvas e restrições (budget, caps, pisos, dispersão desejada, etc.). É aqui que a IA sustenta a pergunta que importa: “qual é o comportamento esperado do plano em diferentes futuros?”. Ou “o que acontece com o custo do ILP se a ação dobrar de valor?”.

LLMs e agentes entram para acelerar análise, reduzir fricção de consulta e apoiar governança (respostas rastreáveis, fontes controladas, versionamento). Não substituem o desenho, mas mudam a produtividade e a qualidade do diagnóstico quando ancorados em dados internos/validados.

O problema real: metas e simulações falham quando tratam incerteza como detalhe

Remuneração variável e ILP falham menos por “falta de boa intenção” e mais por uma limitação clássica: incerteza mal modelada.

- Metas são definidas como pontos únicos (um número), quando na verdade deveriam refletir uma distribuição de resultados possíveis.

- Planos são avaliados por poucos cenários determinísticos (“se o EBITDA der X…”), sem medir dispersão, caudas e risco de custo.

- ILPs são aprovados sem um mapa claro de sensibilidade: volatilidade, correlação setorial, condições de mercado e probabilidade de vesting.

Quando esse diagnóstico é ignorado, surgem efeitos conhecidos: metas fáceis (windfall), metas impossíveis (desengajamento), custo imprevisível (estouro de budget) e incentivos que pagam por sorte (pay-for-luck). O papel da IA, quando bem aplicada, é colocar essa incerteza dentro do processo decisório.

Definição de metas: de “negociação” para calibração estatística

A definição de metas é uma das áreas em que algoritmos mais ajudam, não porque “inventam metas”, mas porque permitem responder perguntas que quase nunca são respondidas com rigor:

- Qual a probabilidade de atingir threshold, target e máximo?

- Qual a dispersão esperada de payout por população?

- Qual o risco de o plano se tornar punitivo em cenários apenas moderadamente adversos?

- Qual o risco de pagar demais em cenários medianos?

A mudança de mentalidade é simples e poderosa:

Uma meta não é um número. É uma escolha de risco.

Na prática, isso significa tratar metas como escolhas sobre percentis e distribuições. O desenho deixa de ser “crescer 12%” e passa a ser: qual percentil do resultado esperado deve ser considerado target, dadas restrições de budget e estratégia? — e isso pode ser calibrado com previsões e simulações.

Onde entram os modelos

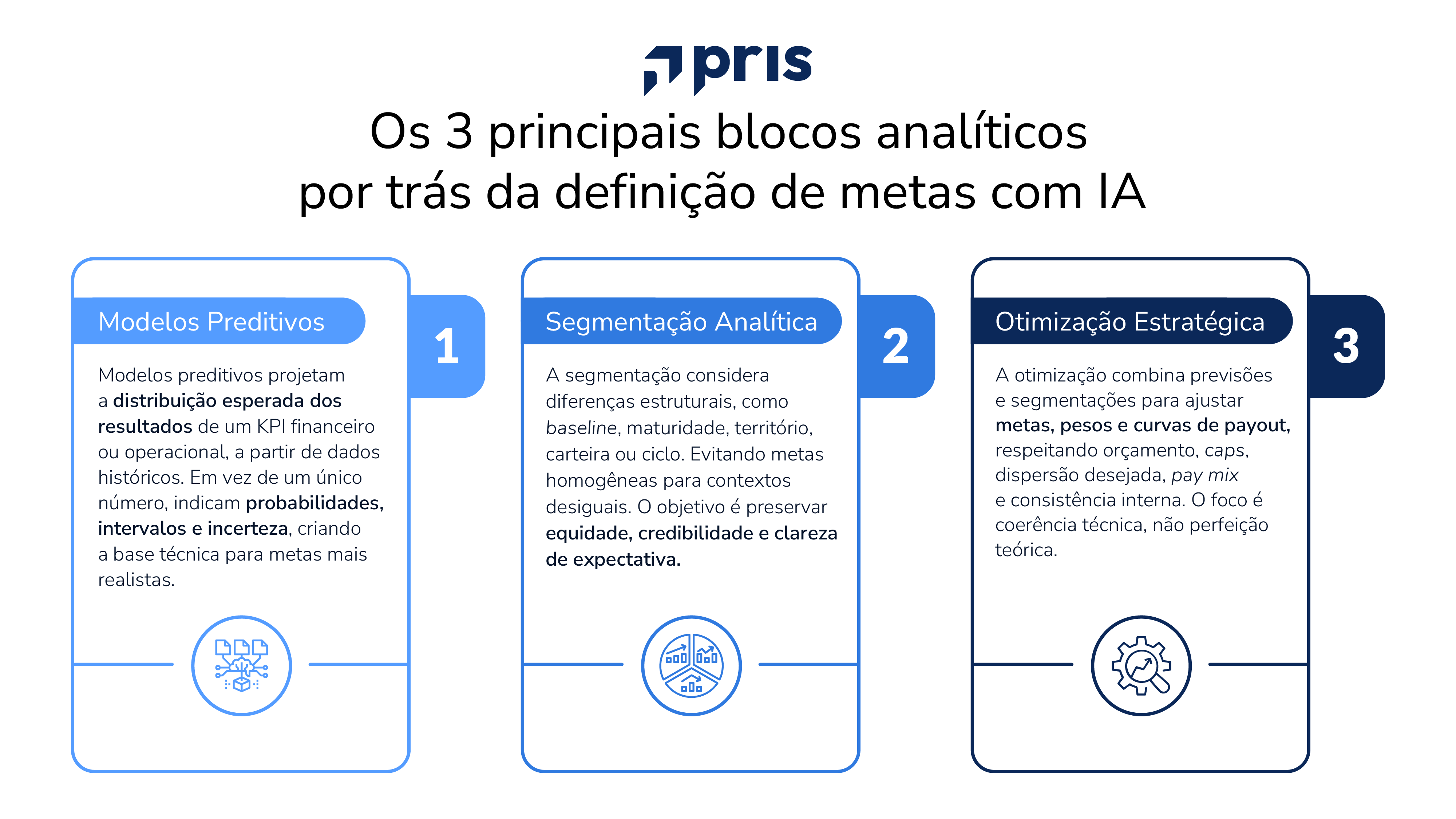

Em termos técnicos, há três blocos analíticos típicos (a escolha depende do contexto e do dado disponível):

Há evidência de que o mercado vem direcionando IA para esse tipo de uso: ferramentas e abordagens em compensação destacam simulação de cenários, detecção de vieses e análises preditivas como parte do pacote de valor (inclusive em incentivos e remuneração).

Simulações: o coração técnico da remuneração bem desenhada

Se existe um “centro de gravidade” para IA em remuneração estratégica, ele é a capacidade de simular. Simulações robustas respondem quatro perguntas diferentes e, por isso, não deveriam ser confundidas:

- Cenários determinísticos (what-if)

Servem para comunicação e governança: “se o indicador ficar em X, paga quanto?”. São úteis, mas capturam pouco da incerteza.

- Simulação probabilística (Monte Carlo)

Serve para risco e custo: “qual a distribuição de payouts e o risco de estourar budget?”. Em ILP, Monte Carlo é particularmente relevante para modelar trajetórias de preço/TSR e condições de performance.

- Backtesting

Serve para validação: “se esse plano existisse nos últimos ciclos, como teria se comportado?”. Ajuda a reduzir surpresa e arbitrariedade.

- Stress test

Serve para robustez: “em cenários extremos, o plano quebra?”. É aqui que caps, pisos, malus/clawback e regras de governança precisam conversar com simulação.

A maturidade não está em “rodar simulações”. Está em ter clareza de qual pergunta cada simulação responde e em documentar premissas, fontes e limitações, exatamente o tipo de disciplina que consultorias globais recomendam ao discutir governança e qualidade de dados em aplicações de IA para remuneração.

IA em remuneração variável: metas, orçamento e consistência

Em RV anual, a IA agrega em três eixos principais:

-

Calibração de metas com base em previsões e probabilidade de atingimento.

- Simulação de orçamento e dispersão (pool e impacto por população) antes do comitê fechar o ciclo.

- Controle e consistência: reduzir divergência entre áreas, detectar outliers, apontar riscos de equidade e sustentar decisões gerenciais com evidências, sem eliminar a decisão humana.

Esse “sem eliminar a decisão humana” não é detalhe: é a fronteira ética e de governança. Discussões recentes sobre algoritmos em decisões de pessoas reforçam a importância de transparência, governança e accountability para mitigar riscos de vieses e opacidade (“black box”).

IA em ILP: quando dados, simulação e governança se tornam vantagem competitiva

ILP (ações, PSUs, performance shares, stock options, phantom shares) é onde a IA pode gerar ganhos desproporcionais, por dois motivos:

- A incerteza é estrutural (mercado, volatilidade, macro, correlação setorial).

- O volume de dados e documentos é alto (planos, formulários, histórico, métricas, regras).

Dados públicos e o Formulário de Referência (CVM) como insumo analítico

No Brasil, parte relevante do ILP está descrita em documentos públicos associados à CVM, com estrutura e orientações normativas. A própria CVM publica orientações sobre o envio e a estrutura do Formulário de Referência sob normas como a Resolução CVM nº 80/22, e recomenda acompanhamento de atualizações e decisões do colegiado.

O item 8.4 do Formulário de Referência, por exemplo, é explicitamente voltado à descrição do plano de remuneração baseado em ações e seus termos e condições (há documentos públicos que exemplificam esse tipo de conteúdo).

Onde a IA muda o jogo: da leitura manual à extração estruturada + simulação

Um aprendizado prático debatido no ecossistema de ILP é que não basta “subir PDFs” em um chat. Há limite de contexto, risco de ruído e aumento de falsos positivos/negativos. Sem uma arquitetura de RAG, a IA pode inventar cláusulas de vesting que não existem no documento original. Uma abordagem mais robusta envolve quebrar documentos, vetorizar, recuperar apenas trechos relevantes e controlar versionamento, reduzindo alucinação e permitindo rastreabilidade de fonte, especialmente quando o objetivo é apoiar decisões que serão auditadas.

Essa lógica é consistente com o que fornecedores globais vêm enfatizando: respostas precisam ser rastreadas a fontes de dados, com transparência sobre como foram geradas e com governança de dados como pré-requisito.

O que passa a ser possível em ILP (de forma defensável)

Quando documentos e dados são estruturados e combinados com simulação/otimização, a organização consegue responder, com mais precisão:

- Quais métricas de performance aparecem com maior frequência por setor/segmento (lucro, EBITDA, FCF, TSR etc.)?

- Qual o histórico de programas (outorgas, elegibilidade, regras) e sua evolução ao longo do tempo?

- Qual a sensibilidade do plano a diluição, descontos, métricas e condições?

- Que simulações deveriam ser mandatórias (por exemplo, Monte Carlo para trajetórias de preço/TSR e condições de vesting)?

Em resumo: ILP deixa de ser “benchmark pontual” e passa a ser engenharia de incentivos com evidência e simulação.

Governança: o que separa “IA útil” de “IA perigosa” em remuneração

Remuneração é uma das funções mais sensíveis do RH, porque afeta custo, comportamento e percepção de justiça. Por isso, a governança não é acessório. Ela é o próprio mecanismo de confiança

Três pilares inegociáveis

- Qualidade de dados: sem dados confiáveis, o modelo produz ruído com aparência de precisão.

- Governança de dados: políticas, validação, consistência, atualização e controle de versões para evitar decisões baseadas em “norma antiga” ou base inconsistente.

- Rastreabilidade e transparência: responder “de onde veio isso” é parte do processo — e fornecedores têm colocado isso como premissa de ferramentas de inteligência em remuneração.

Essa exigência está alinhada ao debate mais amplo sobre transparência e explicabilidade em decisões algorítmicas aplicadas a pessoas, inclusive com técnicas de XAI (métodos que tornam transparentes e interpretáveis as decisões de modelos de IA, permitindo entender, auditar e justificar como e por que um determinado resultado foi gerado) para reduzir opacidade e aumentar accountability.

Roteiro prático (e tecnicamente sólido) para começar a implementar IA

Para implementar IA de forma madura em metas e simulações, há uma sequência lógica que evita desperdício:

O ganho não é apenas eficiência. É elevar a qualidade do debate interno: um comitê decide melhor quando consegue enxergar custo, risco e dispersão antes de aprovar metas e curvas.

Conclusão: IA como disciplina de decisão, não como atalho

A remuneração estratégica continua exigindo julgamento, alinhamento com estratégia e governança. A IA não muda isso. O que ela muda é a base técnica da decisão: metas deixam de ser tratadas como números únicos e passam a ser escolhas probabilísticas; simulações deixam de ser exceção e viram fundamento; ILP deixa de ser leitura manual e vira análise estruturada com rastreabilidade.

Em um mercado em que a função de rewards sofre pressão crescente por transparência, equidade e ROI, a vantagem competitiva não está em “ter IA”. Está em ter dados, método, simulação e governança. Com isso, fazer da remuneração uma disciplina mais precisa, mais defensável e mais conectada ao negócio.